Aumento de Dados: A Mágica de Criar Mais com Menos para Turbinar sua IA

Seu modelo de Inteligência Artificial, treinado por horas a fio com dados impecáveis, finalmente vai para o mundo real... e falha miseravelmente. A causa mais comum para essa frustração não é um algoritmo complexo, mas algo muito mais fundamental: um dataset de treinamento pequeno, repetitivo ou pouco diversificado. Modelos de Deep Learning são como atletas de elite: seu desempenho depende da qualidade e variedade do seu treino. Sem um "banquete" de exemplos, eles se tornam frágeis e incapazes de generalizar. E se fosse possível multiplicar esse banquete sem coletar um único dado novo? Bem-vindo ao universo do Aumento de Dados (Data Augmentation), a técnica que transforma escassez em abundância.

Longe de ser um mero truque, esta é uma estratégia essencial na caixa de ferramentas de qualquer cientista de dados ou engenheiro de machine learning. Ela permite criar modelos de IA mais robustos, precisos e, crucialmente, generalizáveis, transformando um conjunto de dados limitado em um ativo vasto e poderoso.

O que é, Exatamente, o Aumento de Dados?

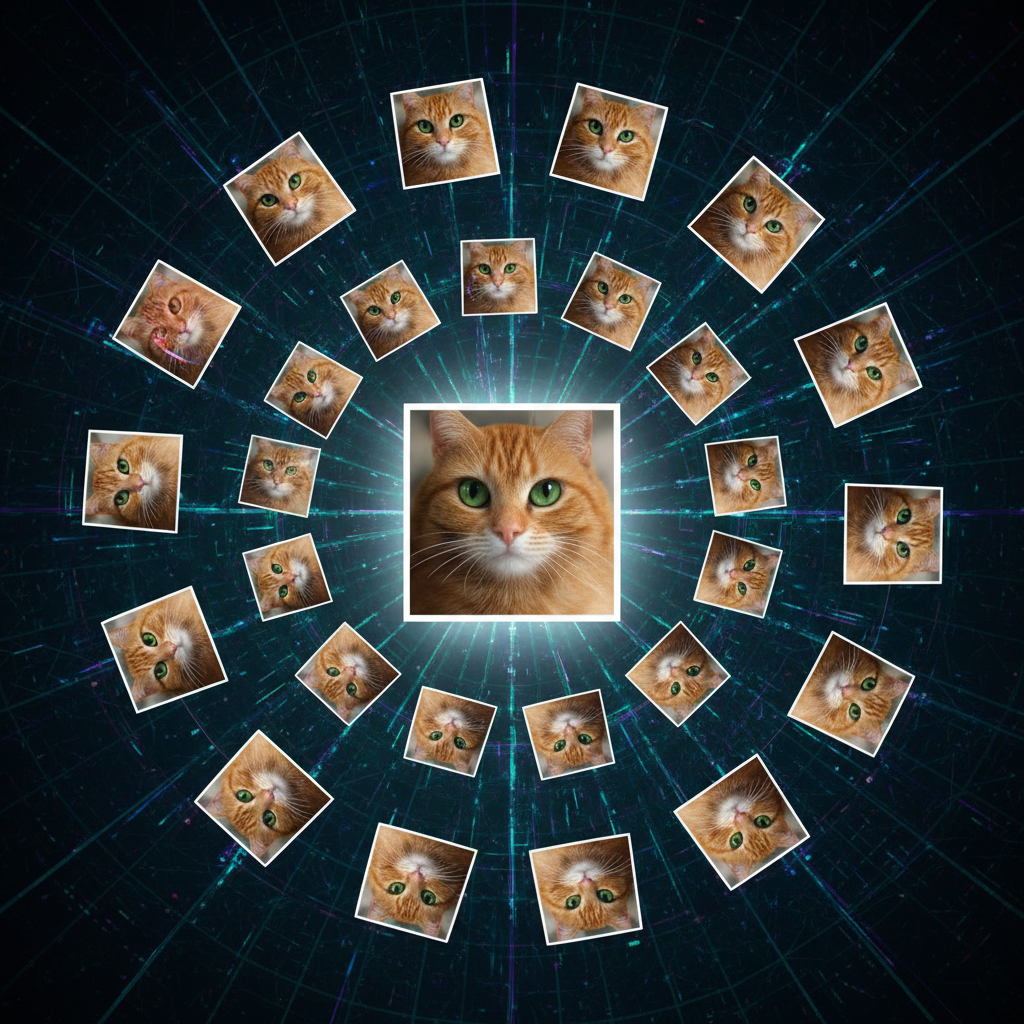

Imagine treinar um modelo de visão computacional com apenas 100 fotos de gatos. Ele pode aprender a identificar um gato em uma pose específica, mas provavelmente falhará se o animal estiver de lado, sob uma luz diferente ou parcialmente obscurecido. O Aumento de Dados resolve isso criando, artificialmente, novas amostras de treinamento a partir dos dados existentes, através da aplicação de transformações pequenas e realistas.

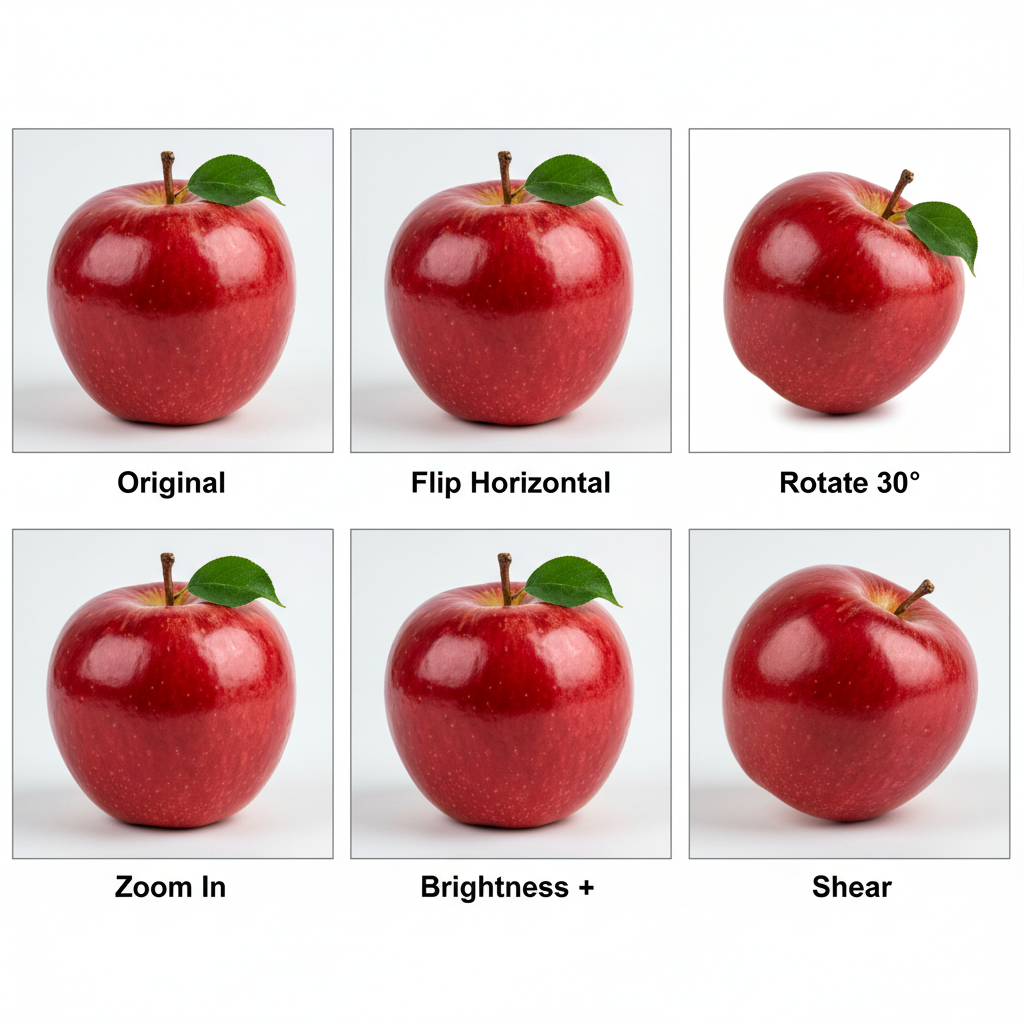

Para cada foto, podemos gerar dezenas de variações: rotacionar a imagem levemente, aplicar zoom, espelhá-la horizontalmente, ajustar o brilho ou o contraste. De repente, suas 100 fotos originais se transformam em 500, 1.000 ou mais exemplos únicos. A premissa fundamental é que a classe do objeto permanece inalterada (um gato rotacionado ainda é um gato). Este processo ensina ao modelo o conceito de invariância — a habilidade de reconhecer um objeto independentemente de sua posição, escala, iluminação ou perspectiva. Em suma, torna o modelo mais inteligente e adaptável ao caos do mundo real.

Os Benefícios Estratégicos do Data Augmentation

Adotar o Aumento de Dados vai muito além de simplesmente "ter mais dados". As vantagens são profundas e impactam diretamente o sucesso e a viabilidade do seu projeto:

- Construa Modelos à Prova de Falhas (Combatendo o Overfitting): Este é o benefício mais celebrado. O overfitting (superajuste) ocorre quando o modelo "decora" os dados de treino em vez de aprender os padrões reais. Ao ser exposto a uma diversidade massiva de exemplos, o modelo é forçado a focar nas características que realmente definem um objeto, tornando-se drasticamente mais preciso com dados inéditos.

- Maximize o ROI do seu Dataset (Reduzindo Custos): Coletar e rotular dados de alta qualidade é um processo notoriamente caro e demorado. O Aumento de Dados é uma alternativa econômica que multiplica o valor do investimento já realizado no seu dataset, sem custos adicionais de coleta ou rotulagem.

- Alcance a Generalização Real (Criando Robustez): Modelos treinados com dados aumentados são inerentemente mais robustos. Eles performam melhor em cenários do mundo real porque foram preparados para lidar com a variabilidade natural e as imperfeições que encontrarão em produção.

Técnicas de Aumento de Dados por Domínio de Aplicação

As técnicas variam conforme o tipo de dado (imagem, texto, áudio), mas o princípio de criar variações plausíveis é universal. Vamos explorar as aplicações mais comuns.

Para Visão Computacional: O Playground Clássico

Esta é a área onde o Aumento de Dados brilha com mais intensidade. As transformações são intuitivas e extremamente eficazes para ensinar os modelos a "verem" melhor.

- Transformações Geométricas: Rotação, translação (deslocamento), zoom, cisalhamento (shear) e inversão horizontal/vertical (flip).

- Transformações de Cor e Iluminação: Alterações de brilho, contraste, saturação e matiz (hue), simulando diferentes condições de luz.

- Oclusão e Ruído: Adição de ruído gaussiano, remoção de patches da imagem (cutout/dropout) ou embaralhamento de blocos (grid shuffle) para forçar o modelo a aprender com informações parciais.

- Técnicas Avançadas (Mixing): Métodos como Mixup (que cria novas imagens combinando duas imagens e seus rótulos) e CutMix (que recorta uma porção de uma imagem e cola em outra) geram exemplos desafiadores que ensinam o modelo a fazer predições menos "confiantes" e mais suaves, melhorando a calibração e a generalização.

Mão na Massa: Implementando com TensorFlow e PyTorch

Os principais frameworks de Machine Learning oferecem ferramentas poderosas e fáceis de usar para aplicar essas técnicas em tempo real durante o treinamento.

Exemplo com TensorFlow (Keras):

# Importando as ferramentas necessárias do TensorFlow/Keras

from tensorflow.keras.preprocessing.image import ImageDataGenerator

# Criando um gerador de dados que aplica transformações em tempo real

# Documentação completa em: https://www.tensorflow.org/api_docs/python/tf/keras/preprocessing/image/ImageDataGenerator

data_generator = ImageDataGenerator(

rotation_range=30, # Rotação aleatória de -30 a +30 graus.

width_shift_range=0.2, # Desloca horizontalmente até 20% da largura da imagem.

height_shift_range=0.2, # Desloca verticalmente até 20% da altura da imagem.

shear_range=0.2, # Aplica distorção de cisalhamento (inclinação).

zoom_range=0.2, # Aplica zoom aleatório entre 80% e 120%.

horizontal_flip=True, # Permite espelhamento horizontal (ótimo para fotos).

fill_mode='nearest' # Preenche novos pixels (criados pela rotação/deslocamento)

# com o valor do pixel mais próximo.

)

# Este gerador é usado diretamente na função model.fit(), aplicando

# transformações diferentes a cada imagem em cada época de treinamento.

# model.fit(data_generator.flow(x_train, y_train, batch_size=32), ...)

Exemplo com PyTorch (Torchvision):

# Importando as transformações do pacote Torchvision

import torchvision.transforms as transforms

# Compondo uma pipeline de transformações sequenciais

# Explore todas as opções em: https://pytorch.org/vision/stable/transforms.html

data_transforms = transforms.Compose([

transforms.RandomRotation(30), # Rotaciona a imagem até 30 graus.

transforms.RandomResizedCrop(224), # Recorta uma área aleatória e redimensiona para 224x224.

transforms.RandomHorizontalFlip(), # Aplica espelhamento horizontal com 50% de chance.

transforms.ColorJitter(brightness=0.2, # Altera aleatoriamente brilho, contraste e saturação.

contrast=0.2,

saturation=0.2),

transforms.ToTensor(), # Converte a imagem (PIL/numpy) para um Tensor PyTorch.

transforms.Normalize(mean=[0.485, 0.456, 0.406], # Normaliza cada canal de cor com média e desvio padrão

std=[0.229, 0.224, 0.225]) # calculados no dataset ImageNet. Acelera a convergência.

])

# Essa pipeline de transformações é passada para o seu objeto Dataset do PyTorch.

# train_dataset = CustomImageDataset(..., transform=data_transforms)

Para Processamento de Linguagem Natural (PLN): Preservando o Sentido

Em PLN, o desafio é criar variações que preservem a semântica original do texto.

- Substituição de Sinônimos: Trocar palavras por sinônimos usando um dicionário como o WordNet. Ex: "O carro era veloz" -> "O carro era rápido".

- Back-Translation: Traduzir uma frase para outro idioma (ex: inglês -> alemão) e, em seguida, traduzi-la de volta para o original. O resultado é uma nova frase, parafraseada, mas com o mesmo significado.

- Inserção e Deleção Aleatória: Adicionar ou remover palavras que não alteram o sentido central, como stopwords (e, a, o, de).

- Contextual Word Embeddings: Utilizar modelos de linguagem como o BERT para substituir palavras por outras que façam sentido no mesmo contexto, gerando variações mais ricas e realistas.

Para Áudio e Reconhecimento de Fala: Adaptando-se ao Ruído

Para tarefas como Reconhecimento de fala ou classificação de sons, as técnicas simulam variações do ambiente real.

- Adição de Ruído: Inserir ruídos de fundo realistas (rua, café, escritório) para tornar o modelo robusto a ambientes barulhentos.

- Pitch Shifting e Time Stretching: Alterar o tom (pitch) para simular vozes diferentes ou a velocidade (stretching) para simular ritmos de fala distintos.

- SpecAugment: Uma técnica poderosa que opera diretamente no espectrograma do áudio, mascarando (zerando) blocos de frequências ou de tempo, forçando o modelo a aprender a partir de informações parciais do sinal de áudio.

Boas Práticas e Armadilhas a Evitar

Embora poderoso, o Aumento de Dados deve ser aplicado com critério. Uma aplicação inadequada pode degradar a performance do modelo ao invés de melhorá-la.

A Regra de Ouro do Aumento de Dados: A transformação deve criar uma variação plausível que o modelo poderia encontrar no mundo real, sem nunca alterar a verdade fundamental (o rótulo) do dado. Por exemplo, inverter verticalmente uma imagem do dígito "6" o transforma em um "9", corrompendo o dataset. Em imagens médicas, um simples espelhamento horizontal pode confundir a esquerda com a direita de um órgão, um erro com consequências graves. O contexto é tudo. — Sabedoria de um Cientista de Dados Sênior

Siga estas boas práticas para garantir o sucesso:

- Preserve a Classe Original: A transformação nunca deve alterar o rótulo do dado. Pense criticamente se uma transformação faz sentido para o seu domínio específico.

- Separe o Conjunto de Validação ANTES: É crucial separar seu conjunto de validação/teste antes de aplicar o aumento de dados. A validação deve ser feita com dados "limpos" e originais para se ter uma medida real da performance do modelo no mundo real.

- Comece com Sutileza: Não exagere na intensidade das transformações. Rotações extremas, alterações de cor muito drásticas ou ruído excessivo podem criar artefatos que não existem na realidade, ensinando padrões incorretos ao modelo.

- Use Pipelines de Transformação: Combine múltiplas técnicas aleatórias (como nos exemplos de código) para gerar a maior diversidade possível de forma eficiente e controlada, em vez de aplicar apenas uma transformação por vez.

Conclusão: De Semente a Floresta

O Aumento de Dados transcende a definição de "técnica" para se tornar uma filosofia de desenvolvimento em IA. Ele nos capacita a construir sistemas mais inteligentes, justos e resilientes, democratizando o acesso a modelos de alta performance mesmo quando os dados são escassos. Em vez de ver seu dataset como um recurso finito, pense nele como uma semente. Com as ferramentas certas de Data Augmentation, você pode cultivá-lo, transformando um pequeno conjunto de dados em uma floresta vasta e diversificada, pronta para nutrir a próxima geração de modelos de Inteligência Artificial.

0 Comentários