O que é uma Função de Ativação? A Decisão da Rede Neural

Imagine que você está construindo um robô com Inteligência Artificial. Dentro do "cérebro" desse robô, existem milhares de pequenas unidades de processamento, chamadas de neurônios artificiais, que trabalham juntas para tomar decisões. Mas como um neurônio decide se uma informação é importante o suficiente para ser passada adiante? É aí que entra a função de ativação.

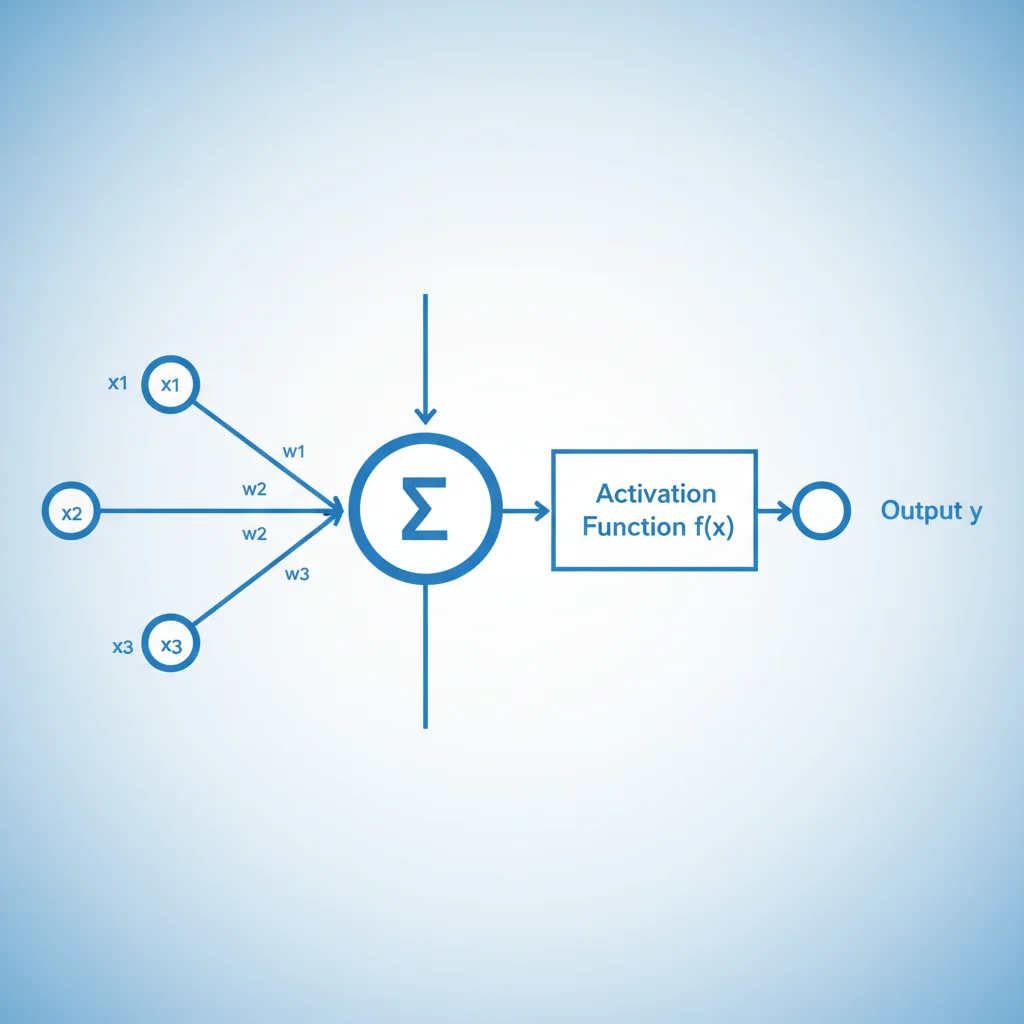

De forma simples, uma função de ativação é uma regra matemática que determina se um neurônio deve ser "ativado" (ou "disparar") ou não. Ela recebe a soma de todas as informações que chegam ao neurônio e a transforma em um sinal de saída. Pense nela como um porteiro: ele analisa quem está tentando entrar e decide se abre ou não o portão.

Sem as funções de ativação, uma Rede neural, não importa quão profunda fosse, se comportaria apenas como um modelo de regressão linear simples. São elas que introduzem a não-linearidade, permitindo que a IA aprenda padrões extremamente complexos, como reconhecer um rosto em uma foto ou traduzir um idioma.

Tipos Comuns de Funções de Ativação (Para Iniciantes)

Existem dezenas de funções de ativação, cada uma com suas particularidades. No entanto, para quem está começando, é fundamental conhecer as mais populares, que são a base para muitas aplicações de IA hoje.

Função Sigmoid

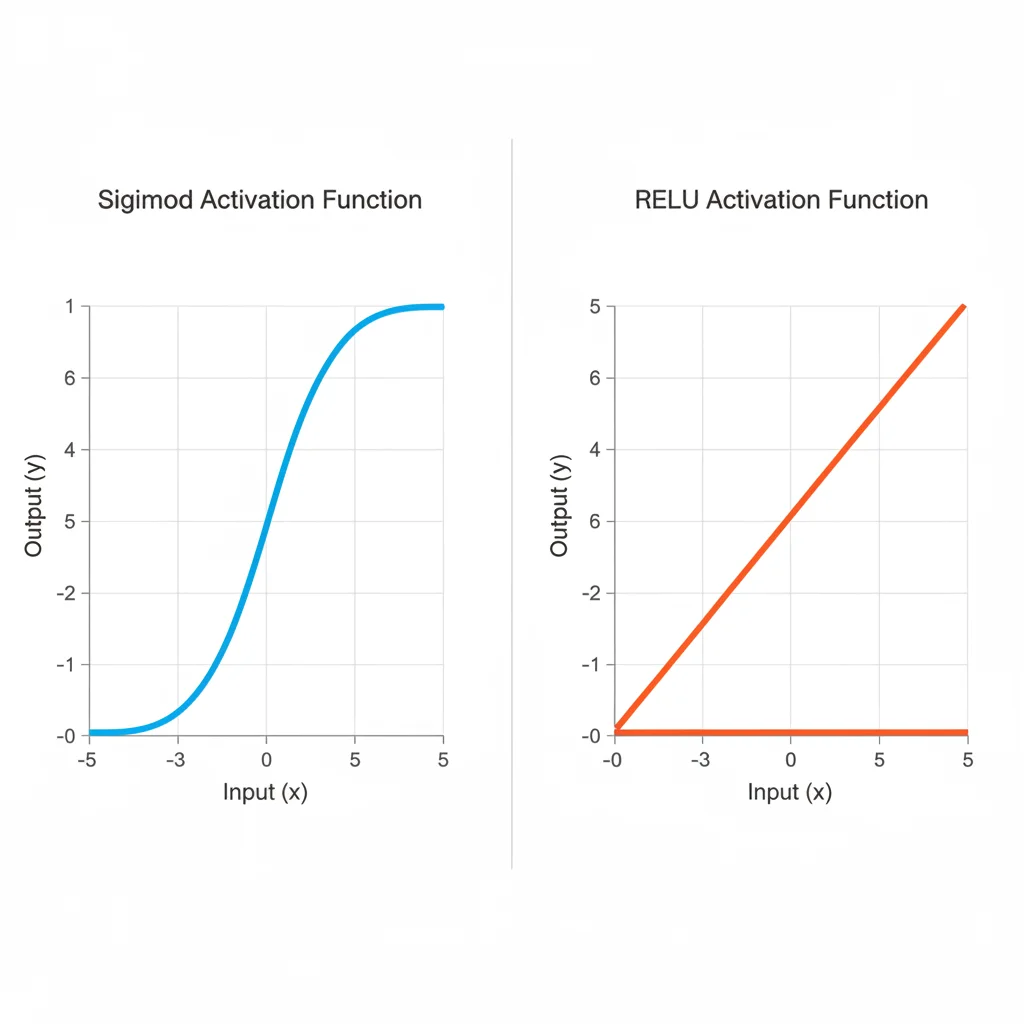

A função Sigmoid é clássica. Ela pega qualquer valor de entrada e o "espreme" para um intervalo entre 0 e 1. Isso é muito útil quando queremos que a saída da nossa rede seja uma probabilidade. Por exemplo, em um modelo que precisa decidir se um e-mail é spam ou não, a Sigmoid pode dar uma saída de 0.9, significando "90% de chance de ser spam". Sua forma de "S" suave a torna ideal para tarefas de classificação binária.

Função ReLU (Rectified Linear Unit)

A ReLU é, de longe, a função de ativação mais usada nas camadas internas das redes neurais atualmente. Sua regra é incrivelmente simples: se a entrada for positiva, a saída é a própria entrada; se for negativa, a saída é zero. Pense nela como uma válvula que só deixa o fluxo positivo passar. Essa simplicidade torna o treinamento da rede muito mais rápido e eficiente, ajudando a evitar alguns problemas comuns que retardam o aprendizado da IA.

Por que a Escolha da Função de Ativação é Importante?

A escolha da função de ativação não é um mero detalhe técnico. Ela impacta diretamente a capacidade de aprendizado e a velocidade de treinamento da rede neural. Uma escolha errada pode fazer com que a rede não consiga aprender os padrões dos dados ou demore muito tempo para ser treinada.

A regra geral é: comece com ReLU para as camadas ocultas (as camadas do meio da rede) e use Sigmoid (ou sua "prima" Softmax, para múltiplas classes) na camada de saída para problemas de classificação. Entender o papel de cada uma é um passo crucial para quem deseja não apenas usar, mas também criar modelos de inteligência artificial eficazes.

Em resumo, as funções de ativação são os verdadeiros motores de decisão dentro de uma rede neural, transformando um amontoado de cálculos em uma poderosa ferramenta de aprendizado.

0 Comentários